Dal punto di vista del filosofo della scienza. In un rapido quanto efficace e chiaro excursus delle posizioni filosofiche sulla conoscenza scientifica della realtà, si porta alla luce la contraddizione, ricorrente nella storia del pensiero, tra una scienza fondata sui dati della realtà e una scienza astratta. Un punto chiave e discriminante nella prospettiva della formazione scolastica. Un’occasione per rendersi conto di quanto concezioni mentali, a volte non rilevate, condizionino i rapporti educativi docente-studente.

Nel nostro tempo l’insegnamento delle scienze soffre spesso, sia a livello divulgativo sia, purtroppo, anche scolastico, di un curioso paradosso: da un lato infatti si continua ancora a rifarsi a un angusto schema meccanicista e riduzionista che proprio i progressi della scienza hanno da tempo superato; dall’altro, contraddittoriamente, si sta diffondendo sempre più rapidamente un’idea in certo senso «anarchica» della scienza stessa, per cui ciascuno dovrebbe costruirsi liberamente un proprio cammino, sicché l’educazione a un generico «atteggiamento» di curiosità e di stupore verso la natura finisce per prevalere sull’insegnamento di contenuti precisi – quando addirittura non si giunge a metterne in dubbio la stessa esistenza, come in alcune proposte avanzate nel corso degli ultimi tentativi di riforma della scuola.

La contraddizione non potrebbe essere più palese, eppure in genere non viene neppure avvertita, al punto che i due approcci convivono, spesso addirittura dentro le stesse persone. Ciò tuttavia è assai meno sorprendente di quanto possa sembrare a prima vista: il relativismo e la riduzione della scienza a semplice «schema concettuale», valido solo all’interno di una determinata cultura e privo di contenuti oggettivi e quindi validi universalmente, sono nati storicamente nell’ambito della filosofia della scienza di impostazione analitica che, nonostante le critiche e le svolte intervenute nel corso del tempo, continua ancora sostanzialmente a rifarsi al modello di razionalità tipico del positivismo logico del Circolo di Vienna, il quale a sua volta era modellato proprio sul razionalismo meccanicista ottocentesco.  [A sinistra: Pisum Sativum]

[A sinistra: Pisum Sativum]

La storia è ben nota e d’altra parte non può certo essere esposta per esteso in questa sede:(1) vale tuttavia la pena di riassumerne brevemente i punti essenziali. L’empirismo radicale dei neopositivisti, che per l’ansia di distruggere la possibilità stessa di un pensiero metafisico e religioso avevano ridotto la ragione umana alla sola funzione di combinare, tramite la logica matematica, le (supposte, ma in realtà inesistenti) percezioni elementari dette, significativamente, anche «atomiche», aveva finito per negare, in maniera non meno radicale, benché contro le sue stesse intenzioni originali, anche la possibilità stessa della scienza.

Questo punto venne evidenziato da Karl Popper, il quale rilevò giustamente che le leggi naturali scoperte dalla scienza pretendono di valere in ogni tempo e in ogni luogo e sono quindi autentiche proposizioni universali che, come tali, non possono mai, in linea di principio, essere ridotte a una semplice «collezione» di fatti particolari e richiedono dunque, per la loro ideazione, un intervento autenticamente creativo da parte dell’uomo.

Tuttavia nemmeno Popper ammise che tale aspetto creativo fosse opera della ragione: egli infatti lo definì «irrazionale» e analogo alla creazione artistica, confinando la parte razionale dell’impresa scientifica al solo momento del controllo delle teorie, attuato attraverso la deduzione per via logica di previsioni di fatti particolari da mettere a confronto con i risultati sperimentali. Anche per Popper dunque, come già per i suoi avversari, la razionalità scientifica coincideva in ultima analisi con la logica.

Infine, la svolta relativista degli anni Sessanta, la cui onda lunga dura tuttora, portò alle estreme conseguenze quella che in realtà era già una implicazione inevitabile delle posizioni popperiane e neopositiviste: se infatti la costruzione di teorie autenticamente universali o non è possibile (Circolo di Vienna) o richiede comunque un «salto» logico (Popper), e se d’altro canto la loro verifica o si riduce a una pura tautologia (come per i neopositivisti) o si riduce alla sola falsificazione, senza che sia mai possibile arrivare a dire che anche una sola proposizione scientifica sia vera (Popper), allora è chiaro che la pretesa che la scienza abbia dei contenuti oggettivi è in definitiva arbitraria e tutto si riduce a un gioco di interpretazioni, dipendenti in ultima analisi dalla particolare cultura in cui si vive – che la si chiami «paradigma» (Kuhn), «rete concettuale» (Quine, Van Fraassen), «schema» (Rorty, Davidson) o «realismo interno» (Putnam) – o addirittura a una pura questione di gusti personali (Feyerabend).(2)

Tutto ciò, però, vale (ed è anzi inevitabile) solo se si resta chiusi dentro a un modello di razionalità meccanica e formalistica.

Tuttavia non esiste alcun motivo reale, ma solo una pura opzione – essa sì arbitraria – per sostenere che la ragione si riduca alla logica e non abbia in sé alcuna capacità creativa, come hanno invece sempre ritenuto tutti i più grandi scienziati, a cominciare da Einstein e, prima ancora, da Galileo.

Inoltre, come già si accennava all’inizio, lo sviluppo stesso della scienza contemporanea si è incaricato di dimostrare falso, o perlomeno troppo limitato, proprio quel modello meccanicista (inteso come chiave di lettura della realtà tutta) a cui questo tipo di filosofia si ispira.

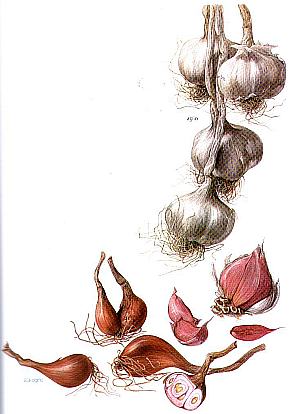

Da un lato, infatti, gli sviluppi della psicologia della Gestalt hanno dimostrato che le supposte percezioni elementari in realtà non esistono affatto e che noi prima percepiamo strutture complesse e solo in un secondo momento possiamo andare a isolare al loro interno elementi più semplici, senza peraltro che tale processo possa mai giungere a individuare oggetti che possano realmente dirsi «elementari», nel senso di non ulteriormente scomponibili.  [A destra: Alium Sativum e Alium Ascalonicum]

[A destra: Alium Sativum e Alium Ascalonicum]

Dall’altro, la fisica del XX secolo ha dimostrato l’insufficienza del modello meccanicista (nonostante i suoi molti e indiscutibili meriti, sia chiaro) anche come chiave di lettura della realtà materiale nel suo complesso.

Dapprima infatti la relatività e la meccanica quantistica hanno mostrato come lo spazio (o «vuoto» che dir si voglia) non è affatto quel «contenitore» inerte e indipendente da ogni altra cosa che si pensava fino alla fine dell’Ottocento, ma è al contrario qualcosa di straordinariamente complesso e «vivo», che interagisce continuamente con i corpi, che è capace di curvarsi, forse addirittura di «bucarsi » e dal quale sgorgano a ogni istante miliardi e miliardi di nuove particelle, per poi essere nuovamente riassorbite e nuovamente rigenerate, in uno zampillio rigoglioso e senza fine.

Inoltre, le due grandi rivoluzioni scientifiche di inizio secolo hanno mostrato come la materia possa trasformarsi in energia e viceversa e come le stesse particelle elementari possano trasformarsi le une nelle altre, in un modo che non può più essere spiegato nei termini del meccanicismo, che prevede che tutto si riduca al movimento, all’aggregazione e alla separazione di parti elementari e immutabili.

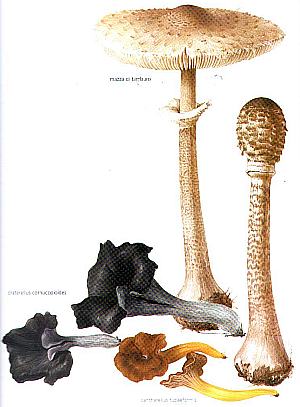

Se tutto questo poteva ancora sembrare valido a livello fondamentale, ma non a quello della nostra esperienza ordinaria, la terza grande rivoluzione scientifica del secolo appena trascorso, quella del caos e della complessità, si è incaricata proprio di colmare questo vuoto, rendendo il riduzionismo meccanicista impraticabile anche al livello mesoscopico (come talvolta si chiama quello delle cose del nostro ordine di grandezza, che stanno a metà strada fra l’infinitamente piccolo e l’infinitamente grande).  [A sinistra: Lepiota Procera e Craterellus Cornucopioides]

[A sinistra: Lepiota Procera e Craterellus Cornucopioides]

Infatti il fenomeno del caos deterministico, scoperto(3) da Edward Lorenz nel 1962, va a mettere in discussione, almeno per la grande maggioranza dei sistemi fisici reali (cioè non idealizzati), il presupposto meno noto ma più fondamentale del meccanicismo, vale a dire la linearità, ovvero il fatto che un errore dell’ordine di grandezza δx nella determinazione delle condizioni iniziali determina un errore dello stesso ordine di grandezza nelle predizioni dopo un qualsiasi intervallo δt.

Lorenz dimostrò invece che questo vale solo per sistemi che presentano condizioni molto particolari e assai rare da trovare in natura, che permettono di utilizzare equazioni, dette appunto lineari, le quali presentano questa caratteristica.

Nella grande maggioranza delle situazioni, tuttavia, è necessario usare equazioni non lineari e in tal caso l’errore si mantiene costante nel tempo solo finché abbiamo a che fare con due sole variabili: ma è sufficiente che ne entrino in gioco tre perché l’errore si amplifichi progressivamente nel tempo, fino a causare, prima o poi,(4) la completa perdita di predicibilità del sistema.

Solo per dare un’idea di quanto questo fenomeno sia diffuso, si pensi che perfino i sistemi gravitazionali newtoniani, che del meccanicismo erano l’emblema, sono in realtà lineari solo finché sono coinvolti due soli corpi: ma basta che ne entrino in gioco tre perché subentri il caos e il sistema diventi instabile su periodi medio-lunghi.(5)

Tuttavia il caos non presenta solo aspetti negativi, di limite per la nostra conoscenza. Le dinamiche non lineari hanno infatti dimostrato di avere anche un importante ruolo costruttivo, in quanto da esse scaturiscono proprietà del sistema che non sono prevedibili a partire dall’analisi dei suoi componenti (proprietà «emergenti», come vengono spesso chiamate).

Questo ha restituito dignità al concetto di complessità, che ora non significa più soltanto, come si pensava prima, la semplice «complicazione», dovuta alla presenza di un gran numero di componenti, non dominabili dalla scienza, ma solo per ragioni pratiche e non di principio, bensì una proprietà strutturale e «creativa» della natura, che può aversi anche a partire da regole molto semplici e da pochi componenti, che sono tuttavia capaci, sotto determinate condizioni, di produrre strutture nuove e imprevedibili (e spesso anche molto belle).

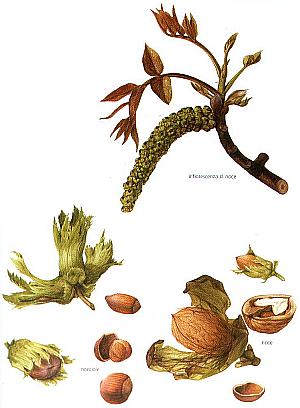

Inoltre, caos e complessità hanno ridato dignità a tutte le scienze, comprese quelle cosiddette soft in quanto non fanno un uso generalizzato della matematica, dimostrando una volta per tutte l’impossibilità di principio (e non solo pratica) del sogno riduzionista di arrivare un giorno a costruire una sola scienza unificata, dai quark fino alla biologia o addirittura all’economia e alla psicologia, per cui, come si usava dire nell’Ottocento (e come purtroppo si sente dire talvolta ancor oggi), tutte le altre scienze non sarebbero in fondo «nient’altro che fisica applicata».  [A destra: Juglans Regia e Corylus Avellana]

[A destra: Juglans Regia e Corylus Avellana]

Al contrario, poiché a ogni livello della realtà compaiono proprietà emergenti nuove e imprevedibili, ne segue che ciascuna scienza deve, per così dire, «ricominciare da capo», individuando i suoi propri oggetti e stabilendo i suoi propri metodi, senza poterli dedurre da nessun’altra (benché, è chiaro, le scienze già consolidate possano fornire, e di fatto forniscano quasi sempre, idee, conoscenze, strumenti e modelli che possono rivelarsi estremamente utili).

Non esistono dunque una scienza «fondamentale» e altre «derivate»: non però nel senso che non ci siano più scienze fondamentali, ma piuttosto in quello che ogni scienza è, nel proprio ordine, tanto fondamentale quanto tutte le altre.

Infine, è importante comprendere come tutto ciò non apra però la porta ad alcun irrazionalismo, come invece talora pare accadere. Tutte queste teorie, infatti, hanno grandemente accresciuto la nostra comprensione della realtà, anche quando, come nel caso dei quanti e del caos, pongono dei limiti alla nostra capacità di conoscerla e di prevederla.

Infatti esse ci dicono le ragioni per cui in determinati casi tali limitazioni esistono: e ce le dicono non in maniera vaga o metaforica, ma, al contrario, in base a precisi e rigorosi calcoli matematici, i cui fondamenti si trovano nella scienza classica, che dunque non viene affatto ripudiata, ma solo integrata e completata. Neanche il meccanicismo viene rinnegato, ma solo messo al suo giusto posto, contestandone non le grandi e importanti conquiste che esso ha permesso, bensì solo la sua pretesa (o, per meglio dire, quella di alcuni suoi troppo entusiastici sostenitori) di essere non «una» chiave, bensì «la» chiave di lettura della realtà tutta.

Per questo dunque, in conclusione, è importante che nell’insegnamento delle scienze i ragazzi vengano educati da un lato a un concetto di ragione più ampio e flessibile di quello tipico del razionalismo positivista e a un concetto di realtà più ricco e articolato di quello tipico del meccanicismo ottocentesco, ma dall’altro anche a tutto il rigore e la precisione metodologica che sono indispensabili non solo per poter essere un domani dei bravi scienziati o tecnici (per coloro che vorranno intraprendere tale carriera), ma anche e soprattutto per comprendere realmente e apprezzare fino in fondo proprio tali concetti più ampi e profondi di ragione e di realtà.

E questo punto, a differenza del primo, che è pur sempre per una minoranza, riguarda davvero tutti.

Vai all’articolo in formato PDF

Paolo Musso

(Filosofia della Scienza – Università dell’Insubria – Varese)

Note

- Per questo rimando al mio recente libro Forme dell’epistemologia contemporanea, Urbaniana University Press, 2004

- Per lo meno il «primo» Feyerabend, giacché egli nei suoi ultimi anni di vita ha cercato insistentemente una via d’uscita, non a caso invocando per questo un concetto di ragione più flessibile e meno angusto (su ciò si veda sempre Forme dell’epistemologia contemporanea)

- O, per meglio dire, riscoperto, in quanto già Poincaré, alla fine dell’Ottocento, se ne era accorto: ma, in parte a causa dell’insufficienza degli strumenti allora disponibili (questi fenomeni infatti non possono ssere studiati senza l’ausilio di potenti computer), in parte a causa dello sconvolgimento causato di lì a pochi anni dalla relatività e dalla meccanica quantistica, le sue intuizioni non vennero sviluppate e caddero presto nel dimenticatoio

- La velocità di tale processo è variabile, anche di molto, da sistema a sistema. Un modo, approssimato ma efficace, di stimarla è il calcolo della dimensione frattale dell’attrattore (cioè, in parole povere, della curva) che descrive il comportamento del sistema. La dimensione frattale, scoperta da Benoît Mandelbrot negli anni Settanta, misura (sempre in parole povere) quanto una curva è frastagliata: più elevata è la dimensione frattale, più rapida è la perdita di predicibilità del sistema. Su questo e su tutta la tematica relativa a caos e complessità rinvio al mio Filosofia del caos, Franco Angeli, 1997.

- Questo significa che anche il sistema solare è instabile. Tuttavia, per nostra buona sorte, grazie alla quasi perfetta circolarità delle orbite e al fatto che la maggior parte della massa è concentrata in due soli corpi, il Sole e Giove, la dimensione frattale è molto bassa e si può ragionevolmente stimare che per almeno 700 milioni di anni non dovrebbero verificarsi sconvolgimenti troppo radicali.

© Pubblicato sul n° 24 di Emmeciquadro