“Caos il vuoto primordiale, una specie di gorgo buio che risucchia ogni cosa in un abisso senza fine paragonabile a una nera gola spalancata” (Giulio Guidorizzi, Il mito greco. Gli dei). Gli antichi greci, nello specifico, associavano il caos ad un qualcosa di complesso perché imprevedibile e sfuggente, non “schematizzabile”. Nella moderna fisica matematica invece “la teoria del caos” è lo studio di modelli applicati a sistemi dinamici che esibiscono una sensibilità esponenziale, intesa come variabilità impercettibile rispetto alle condizioni iniziali, che però va a modificare l’intero sistema. In parole molto povere: condizioni di partenza apparentemente simili portano ad un risultato finale assai differente dal previsto, il tutto causato da variazioni quasi impercettibili. I sistemi caotici, pur governati da leggi deterministiche, risultano invece apparentemente dotati di causalità, legata alle variabili. In realtà questa causalità è apparente: semplicemente non abbiamo, ad oggi, mezzi per una completa previsione.

La pandemia in corso ha evidenziato alcuni problemi di carattere matematico previsionale che forse pensavamo di risolvere abbastanza facilmente, ma che invece ci hanno inchiodato a questa serie di criticità: i modelli matematici detti Sir e Seir non garantiscono un quadro completo perché deterministici (ovvero, predeterminati); sono (e saranno) utili nella mappatura conclusiva della pandemia.

Abbiamo però un mondo altamente globalizzato (anche rispetto al periodo della Spagnola) che necessita di modelli caotici e legati alla “singolarità di variabile”, ben enunciata dalla Teoria matematica della Complessità, quindi che prende ad esempio ogni singola variabile in gioco.

Abbiamo quindi bisogno di simulazioni (modelli stocastici, ovvero che tengono in considerazione variabili ed input, che lavorano quindi sulla probabilità e sul dinamismo dello scenario) che richiedono però una strada obbligata: un tracciamento generale (mediante big data, già esistente con social e qualsiasi interazione online, come il modello Sud Corea basato su App) che necessita poi d’estrapolazione dei dati tramite super computer (senza tracciamento ovviamente non serve a nulla).

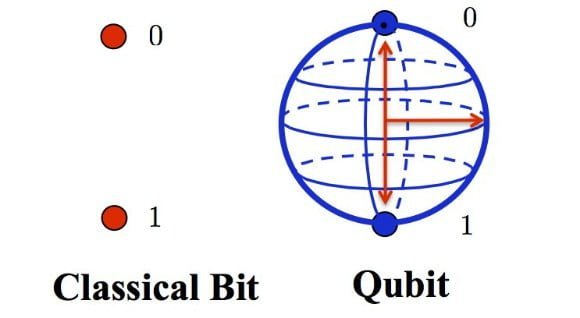

I bit d’un computer hanno percorsi lineari, i qbit dei computer quantistici danzano invece fino a “confondersi”: la loro potenza di calcolo spinta al limite è in grado di simulare una singolarità di movimento e quindi di creare un modello previsionale altamente preciso.

I computer quantistici (per farla breve, il pc che utilizzate lavora per operazioni tra 0 e 1 in codice binario all’interno del volgare bit) elaborano operazioni nel qbit: pensate ad una sfera, partendo dal concetto che 0 e 1 possono essere nel mentre essere sia 0 che 1. Tradotto, le potenzialità di calcolo sono illimitate).

Come streghe danzatrici intorno al fuoco in attesa d’incantesimo i qbit donano ai computer di questo livello margine d’errore prossimo allo 0 sull’evoluzione del virus: in pratica restituiscono il calcolo simulato della singolarità in un sistema caotico, il tutto partendo dai big data in simbiosi con questo calcolo gestito da IA e software quantistico.

Ecco una rappresentazione grafica di bit e qbit:

E ora poniamoci alcune domande. L’AI (utilizzo dei big data come in Sud Corea) potrebbe evitare un nuovo lockdown generalizzato? Attualmente la nostra tecnologia non ci permette modelli diversi da Sir e Seir e qualche timido approccio incrociato tra interazione simulata e reale (come fa Immuni, preso in prestito dalla Sud Corea), motivo per cui la prevenzione non passa dal movimento condizionato da AI atto a evitare blocchi non mirati (il tracciamento potrebbe evitare del tutto i blocchi generalizzati, perché il cluster verrebbe azzerato già a livello di micro–movimento) od altro. La previsione è inversamente proporzionale all’intervento: più si previene e meno s’interviene.

Ma allora a quale modello conviene affidarsi? Risultano sostanzialmente insignificanti percentuali utilizzate singolarmente, comparazioni tra pandemie (il nostro mondo è troppo interattivo, la globalizzazione non aveva mai conosciuto pandemie), dati vari che indichino previsioni, siano essi creati per pessimisti od ottimisti. Non è una questione di scuole di pensiero, ma di macro-dati da elaborare nel modo più vicino alla realtà: una virtualizzazione della pandemia che riesca a svilupparne l’iter e prevederne i focolai (per portarla ad implosione).

Miliardi di persone che si muovono a livello globale sono qualcosa di mai simulato prima: la Spagnola esplose in un mondo molto meno “global”, peste o colera – modelli alla mano – esaurirono la propria forza sempre a causa di decessi esponenziali che bloccarono i movimenti e quindi il contagio ad un certo punto collassò (con Ebola invece collassa perché l’elevata mortalità non permette all’infettato di muoversi).

Il Covid-19 invece viaggia su linee d’interazione parallele, continue, a ritroso e quindi, per ora, è complicato ottenere di più, anzi è quasi impossibile non ricorrere a rimedi simili a quelli classici. Rispetto a cento anni addietro abbiamo una scienza medica più avanzata e quindi possiamo ridurre il danno su larga scala; riusciamo, nel caso specifico, ad evitare che il 20% (dati Wuhan, Sud Corea, Brasile, Usa) s’ammali necessitando di cure specifiche (che andrebbero a calare a causa degli operatori sanitari contagiati).

Mentre scriviamo paesi come il Perù risultano quasi al collasso sanitario appunto perché hanno portato in ospedale il 15–20% almeno dei contagiati (non abbiamo dati specifici d’evoluzione matematica del contagio, se non quelli a grandi linee della Johns Hopkins University).

Il dibattito sui modelli previsionali risulta quindi arenato. Per il momento la… Dea del Caos non ci permette una visione caotica d’insieme riguardante l’evoluzione della pandemia. E ci ritroviamo un po’ come gli antichi greci dinanzi al magma caotico.