Una vita lunga e feconda quella di padre Busa, il gesuita ottantottenne che è riconosciuto come il pioniere della linguistica computazionale. Usando il computer come nessuno aveva mai fatto prima, con pazienza, coraggio e ostinazione, ha approfondito il suo rapporto con l’infinito riscoprendo sul fondo «la luce di Dio che illumina ogni uomo e lo chiama». Oggi la sua avventura continua prospettando nuove analisi dei fatti e nuove metodologie di ricerca per ottenere dalla tecnologia del computer tutte le sue potenzialità e metterle al servizio dell’uomo.

Sono passati più di cinquant’anni da quando incontrò Thomas Watson, il fondatore dell’IBM, convincendolo a raccogliere la sfida dell’analisi computerizzata del linguaggio di san Tommaso. Nello sviluppo del suo lavoro ha attraversato i principali nodi della rivoluzione informatica. In particolare, come ha vissuto, a partire dal desiderio iniziale, il rapporto tra ricerca e tecnologia?

È meglio che racconti un po’ di storia. Il mio sogno, quando sono diventato gesuita era di andare in missione, invece i superiori mi hanno chiesto di fare il professore di filosofia scolastica con specializzazione in san Tommaso.

Durante la guerra, dopo aver fatto il cappellano per un anno, mi hanno mandato a fare la libera docenza alla Gregoriana e poi il Ph.D. Vi racconto la storiella della recluta che, ricevuto l’ordine «avanti marsc», non si ferma in attesa del contrordine; il sergente si dimentica di lui e due giorni dopo quello da Padova ha raggiunto Chioggia e «segna il passo» davanti al mare in attesa di nuovi ordini. Io son quello: mi è stato dato l’ordine di studiare san Tommaso, son partito, mi sono rimboccato le maniche e non ho più abbandonato la filosofia. Anche se oggi troppa filosofia è una passerella di estetismi verbali e non la ricerca della Verità.

Mi venne l’idea di cercare nei testi di san Tommaso la documentazione originaria e probatoria delle affermazioni che chiamiamo filosofiche; così è nato il progetto dell’Index Thomisticus.

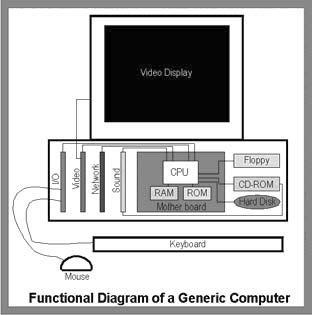

Il linguaggio mi ha messo a contar parole e mi sono reso conto che il nostro parlare, alle sue radici, non lo conosciamo ancora. Ho usato il computer come strumento che permette di andare più in profondità mediante l’osservazione statistica e probabilistica. E mi sono accorto che le parole non hanno confini precisi: sul fondo c’era la luce di Dio che illumina ogni uomo e lo chiama.

Oggi molti pensano che con il computer si possano risolvere tutti i problemi. A suo parere, quali sono le potenzialità dell’informatica dal punto di vista didattico ed educativo?

Gli aspetti educativi dell’informatica linguistica sono legati alla possibilità di rendersi conto che c’è un «pensiero», una «espressione esteriore» e una «espressione interiore».  La mia impressione è che oggi troppa didattica è basata sulla memorizzazione: si concepisce il nucleo del pensiero umano come una banca di dati e allora l’obiettivo dell’apprendimento diventa sapere tutto.

La mia impressione è che oggi troppa didattica è basata sulla memorizzazione: si concepisce il nucleo del pensiero umano come una banca di dati e allora l’obiettivo dell’apprendimento diventa sapere tutto.

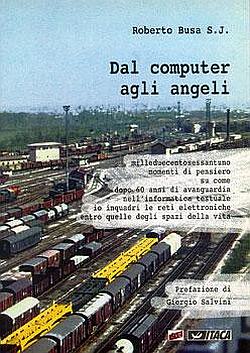

[A sinistra: Roberto Busa S.J.]

Invece, i principi sono questi: le strutture dell’espressione scritta riflettono il fatto che c’è un pensiero originario il quale può dominare la moltitudine delle cose perché le classifica, le riunisce e le esprime con le parole.

C’è un pensiero la cui caratteristica è di non reagire soltanto allo stimolo che c’è, ma anche e soprattutto agli stimoli che non ci sono ancora o non ci sono più. Per esempio: se si iscrive un bambino a scuola è perché si pensa che tra dieci anni, che non ci sono oggi, questo bambino avrà bisogno di avere un lavoro. E i nostri desideri puntano sempre su quello che non c’è, su quello che non si ha (l’uomo è l’unico animale che ha inventato le distillerie!). In questo senso, il linguaggio, soprattutto il linguaggio scritto, non è una ripetizione continua, ma la creazione di architetture sempre nuove.

L’espressione esteriore è quella che noi chiamiamo realtà virtuale: un’immagine non nel senso stretto della parola, iconico, ma immagine come segno e simbolo i quali vengono fatti sussistere in un altro soggetto che non è l’uomo che le pronuncia. Per esempio, la musica della marcia trionfale dell’Aida, creata dalla mente di Verdi, esiste per conto suo, ma sussiste oggi in un’orchestra, domani in un’altra.

C’è anche una espressione interiore: vuol dire che le frasi che si pronunciano sono costruite prima dentro di noi e poi «buttate fuori» mediante la voce. Ma come si costruisce l’espressione dentro di noi è ancora terra sconosciuta.

Può fare un esempio?

Lo spiego con questa storia. All’inizio degli anni Cinquanta, alcuni anni dopo che avevo cominciato, è nata la traduzione automatica (al MIT si pubblicava allora lo MT Mechanical Translation). Il Pentagono aveva finanziato tutti i centri che si offrivano di lavorare sulla traduzione dal russo all’inglese e io avevo collegato il gruppo di Leon Dostert e Peter Toma di Georgetown, università dei miei confratelli di Washington DC con l’Euratom di Ispra per tradurre abstract di biochimica e biofisica russi: per questo abbiamo perforato un milione di parole in cirillico.

Il Pentagono aveva finanziato tutti i centri che si offrivano di lavorare sulla traduzione dal russo all’inglese e io avevo collegato il gruppo di Leon Dostert e Peter Toma di Georgetown, università dei miei confratelli di Washington DC con l’Euratom di Ispra per tradurre abstract di biochimica e biofisica russi: per questo abbiamo perforato un milione di parole in cirillico.

Anche il progetto su san Tommaso, a cui lavoravo sui computer dell’Euratom, era legato a questa iniziativa. Alla metà degli anni Sessanta, a seguito del famoso rapporto ALPAC, il Pentagono improvvisamente sospese i finanziamenti proclamando l’insuccesso della traduzione automatica; tale insuccesso era dovuto non a mancanza di velocità o di memoria dei computer, ma alla mancanza di informazioni filologiche sul nostro parlare, delle quali il computer ha bisogno.

La «vecchia» filologia è basata solo sulla campionatura, sulla massa dei grandi numeri e delle parole che noi cerchiamo; questo non è sufficiente per il computer che ha bisogno di avere dati in percentuale molto approssimati e formalizzati, cioè traducibili in byte.

Per far questo è necessario che sia chiaro in base a quali logiche si parla, logiche che si manifestano con la morfologia, con la sintassi e con il lessico. Dal computer, dal mostro d’accaio, dalla tecnologia usata per l’industria dell’informazione viene la richiesta che si conosca meglio in base a quali elementi e a quali logiche si parla. Se l’umanesimo è la scienza dell’espressione umana in tutte le sue manifestazioni, allora il computer esige che noi uomini abbiamo un umanesimo più spinto.

Dunque il computer chiede all’uomo di conoscere meglio se stesso. Allora quali possono essere i vantaggi nell’imparare attraverso lo strumento informatico piuttosto che con un altro supporto?

Studiare con il computer, in realtà è comunicare: dal mio osservatorio comunico dei bit di informazione agli altri. Quando si tratta di studiare occorre introdurre due elementi: raccogliere dati di fatto, il maggior numero possibile, dalla realtà, mediante l’osservazione; poi questi dati vanno sintetizzati. Questa elaborazione è il lavoro specifico del pensiero, ma per sintetizzare bisogna prima di tutto classificare.

In questo senso io ho fatto due ricerche originali, che non ho trovato in nessuna parte: la prima è sulla eterogeneità delle parole e la seconda sui segni grafici delle parole.

La ricerca sull’eterogeneità delle parole in sanTommaso durò ben otto anni, dal 1983 al 1991. Quali furono i criteri del lavoro? E quali i risultati?

Si trattava di classificare le parole secondo «tipi di semanticità», ossia secondo le diversità dei rapporti tra segno e significato. E richiese alcune migliaia di oreuomo e molta pazienza anche solo per far emergere il criterio per distinguere le categorie delle parole. Perché i rapporti tra significante e significato sono diversissimi in relazione alla semanticità delle parole.  Porto qualche esempio. Ci sono i nomi deittici, come per esempio i due pronomi personali «io» e «tu». Essi hanno come significante due lettere, rispettivamente i-o e t-u, ma il significato di queste parole è che sono segni della conoscenza di una presenza; non sono concetti, perché un concetto prevede una formula. Ma quando io dico «io» la presenza è diversa da quando un altro dice «io». Pensate, anche il Signore, che pure ha inventato padre Busa, non può dire di essere padre Busa.

Porto qualche esempio. Ci sono i nomi deittici, come per esempio i due pronomi personali «io» e «tu». Essi hanno come significante due lettere, rispettivamente i-o e t-u, ma il significato di queste parole è che sono segni della conoscenza di una presenza; non sono concetti, perché un concetto prevede una formula. Ma quando io dico «io» la presenza è diversa da quando un altro dice «io». Pensate, anche il Signore, che pure ha inventato padre Busa, non può dire di essere padre Busa.

[A sinistra: San Tommaso]

Un’altra categoria sono i nomi propri; essi sono nomi etichetta e indicano un oggetto preciso; non esprimono che cosa sia, ma anch’essi sono la conoscenza di una singolarità. Per esempio, sentendo qualcuno che chiama Cicci si sa che c’è un Cicci ma non si sa se sia un gatto, una bambina o un ragazzo. Poi vengono i nomi di oggetti (un tavolo, un cavallo) che gli antichi chiamavano sostanza; sono il soggetto e il complemento oggetto di quei verbi che significano attività e produzione. Anche questi sono nomi etichetta. Quando dico tamarindo so che voglio dire una certa pianta o una certa bibita, anche se non dico niente delle sue proprietà. Poi vengono finalmente gli aspetti delle cose: dimensioni, forme, temperatura, peso, movimento eccetera, che solitamente chiamiamo aggettivi. Son quelli in cui sta tutta la cultura perché sono vere e proprie immagini mentali, veri e propri concetti. Poi vengono le parole che esprimono relazioni e correlazioni cominciando con le preposizioni; infine ci sono parole vicarie come i pronomi relativi e simili.

Ho fatto il censimento di tutte queste parole. Negli 11 milioni di parole dell’Index Thomisticus (siccome Dio l’ho messo tra i nomi propri), con tutti gli altri nomi propri arriviamo al 3%; gli oggetti e le cose arrivano al 6- 8%; la maggior parte dei restanti sono le parole di correlazione.

A questo proposito, mi ricordo che in un congresso un gruppo di scienziati sosteneva che metà delle parole di san Tommaso esprimessero le realtà religiose invisibili. Invece il nome Cristo non è un nome invisibile; è invisibile come è invisibile Socrate. Le realtà invisibili sono poche e sono alla radice del cosmo: Dio, gli angeli, i demoni e i nostri morti. Ma invisibili sono anche le forze di base della natura, dalle forze cosmiche di base (l’elettricità, la gravità, le onde hertziane) ai loro programmatori che sono gli angeli, i software del Signore Dio loro creatore. Questo c’è in san Tommaso, con altre parole naturalmente.

Invece, come ha strutturato la ricerca sui segni grafici?

Avevo 11 milioni di parole latine; riepilogate secondo «forme» di parola graficamente diverse erano circa 150 000; poi avevo «lemmatizzato» ciascuna di esse trovando 20 000 lemmi. Il lemma è quella parola che nei vocabolari rappresenta tutte le proprie flessioni secondo una certa unità che io chiamo unità lessicale che con le flessioni viene arricchita, ma non contraddetta (il lemma è come il corpicino della bambola Barbie e le flessioni sono come gli abitini che le si mettono intorno).

Ho preso tutti i lemmi, li ho divisi in un massimo di tre segmenti (iniziale, centrale e finale), in qualche senso a caso, senza badare al significato e meno ancora alla glottologia, alle derivazione o alle trasformazioni, ma proprio graficamente.

Una stessa stringa di quattro caratteri si trova ripetuta in tante parole all’inizio, come iniziale assieme ad altre stringhe diverse, ma anche in posizione centrale o finale. Ho fatto una classificazione e la mia sorpresa è stata che 11 milioni di parole sono la combinazione di un massimo di 1 500 stringhe diverse di caratteri. Solo 1 500.

Naturalmente ci sono le stesse stringhe con significati diversi.

Nel suo libro Dal computer agli angeli auspica che la statistica linguistica tenga conto della eterogeneità delle parole di un testo e di quella che lei definisce «doppia struttura del lessico ». Può spiegare il significato di questa espressione?

Da sempre è risaputo che quando si parla o si scrive ci sono poche parole diverse, di solito corte, moltissimo ripetute.  Poi ci sono tante parole, relativamente poco ripetute, tra le quali tutte le parole lunghe. Questo l’ho sempre riscontrato e oggi li chiamo i due emisferi del lessico.

Poi ci sono tante parole, relativamente poco ripetute, tra le quali tutte le parole lunghe. Questo l’ho sempre riscontrato e oggi li chiamo i due emisferi del lessico.

[A destra: pagine dei Rotoli di Qumrân]

Il primo lessico, quello delle parole frequenti e brevi, le particelle che a scuola venivano chiamate grammaticali, oggi sono definite dagli inglesi function words e anche close class words perché non aumentano. Esse sono contrapposte a quelle di contenuto, chiamate content words e anche open class words perché cambiano e crescono. Le prime sono quelle che esprimono la logica con cui ciascuno cerca di parlare. Le seconde sono quelle che specificano la cultura, cioè i contenuti che specificano il messaggio.  I due emisferi sono questi: la logica e la cultura. E tra le persone non c’è differenza nella logica di base, ma nella cultura.

I due emisferi sono questi: la logica e la cultura. E tra le persone non c’è differenza nella logica di base, ma nella cultura.

Io non ho lavorato solo le parole di san Tommaso, ma altrettanti milioni di parole in altre 22 lingue e alfabeti diversi: i rotoli di Qumrân, che sono in alfabeto ebraico ma in tre lingue (ebraico, aramaico e nabateo), tutto il Corano in arabo, il finnico, il cirillico, il boemo e ovviamente tutte le lingue europee e il greco; le ultime sono state l’albanese e il giorgiano e poi l’alfabeto fonetico. In tutte queste cose ci sono i due emisferi del lessico.

Nell’oralità non ho fatto calcoli, perché i media espressivi sono tanti e perché nell’oralità il linguaggio è ridotto al minimo. Per esempio, se ordino una birra e dico «cameriere me ne porti un’altra», in questo caso «altra» è la birra; invece, se avessi ordinato una zuppa, «altra» avrebbe un altro significato.

Invece il linguaggio educato è quello scritto. In questa direzione, la critica di un libro si fa al suo interno. Di fronte a un libro non bisogna mettersi con l’idea di confutarlo, ma vedere se quello che dice è coerente con la logica con cui lo dice.

(Dal computer agli angeli, pp. 25-26) |

Recentemente mi hanno chiesto perché lavorare su san Tommaso e non su un testo moderno.

Trent’anni fa mi hanno invitato a Mosca per lavorare sui testi di Lenin con lo stesso metodo. E ho provato a farlo, nei ritagli di tempo, anche sul libro di Jacques Monod (Il caso e la necessità) e poi su quello di Stephen Hawking (Dal big bang ai buchi neri) e in passato l’avevo fatto con il behaveourista Skinner.

Si riesce a vedere il momento in cui i testi di un autore sono illogici: non perché contraddicono san Tommaso o san Bonaventura, ma perché sono illogici in se stessi.

Recentemente i giornali hanno parlato di lei definendola «informatico di scienze umane», invece ci sta facendo una riflessione sull’uomo. Queste categorie valgono in tutti gli ambiti? Anche nel fare scienza?

Facciamo riferimento ai due emisferi. Nel primo emisfero, quello della logica, si vede la luce di Dio che illumina ogni uomo. In tutti i congressi sostengo che tutte le anime e le intelligenze non vengono per evoluzione: le anime sono fatte tutte dal Signore Dio, una per una. È un paradosso, ma utile per chiarire: non ci vuole meno di Dio tutto intero per fare un’intelligenza d’uomo, per fare uno spirito. La luce di Dio è la logica e la logica sono le leggi dell’essere.

Io vedo tre livelli di logica. Quella che si insegna all’università, la logica formale, è il rapporto tra contenente e contenuto, fra tutto e parte.

Un’altra logica, che non viene così studiata, è quella del rapporto tra autore e opera, tra attivo e passivo che è un rapporto strano, perché è a senso unico: nessun figlio è padre del proprio padre, nessuna statua è l’autrice del proprio scultore. Tutti lo sanno: chi ha scritto un’opera va dalla SIAE a farsi dare la percentuale e non dice mai che la sua opera è fatta per caso.

Il terzo livello è quel rapporto tra pensiero ed espressione che è il principio di non contraddizione.

Come dice il nome, la contraddizione ha a che fare con il dire, cioè con l’espressione. Si riesce sempre a pronunciare frasi contraddittorie: per esempio «qui ora piove» e «qui ora non piove», ma nessuno riesce a pensare che ambedue siano contemporaneamente vere, né che ambedue siano contemporaneamente false.

L’espressione non deve contraddire il proprio pensiero: il che conchiude alla immoralità intrinseca della menzogna.

Perché oggi nel mondo della cultura questi livelli di logica sono più spesso negati che affermati? Perché nella comunicazione, nel lavoro, nella scuola, nella scienza, ci si basa di più sul suscitare sensazioni che non sulla logica?

Direi ignorati, moltissimo ignorati e poche volte negati. Nei libri di logica non ho mai trovato il rapporto attivo/passivo, ma sempre il rapporto vero/ falso e poi contenente/contenuto. Ai miei studenti di filosofia, preoccupati di aver letto una gran quantità di autori, dicevo: basterebbe sapere la metà di quel che sappiamo ma saperlo dire meglio il doppio se no è esibizione di quello che abbiamo in magazzino nella memoria.

La storia del linguaggio e della cultura è in fondo storia di anime, storia del colloquio segreto che abbiamo con Dio. Ed è una storia che ha più avventure di quelle di Sandokan e delle Twin Towers.

Perché segreto?

Perché sta nel profondo della logica, perché la logica è data per arrivare a capire il perché di tutto e perché nel vocabolario di tutte le persone c’è la parola «prima» e anche la parola «sempre». Sotto questo luccichio e questo mare di parole c’è la storia delle anime nel tempo: dall’eternità verso l’eternità. Si arriva dunque alla logica come prima luce dell’anima, quella che porta il tempo all’eternità, dall’eternità all’eternità.

Un mio amico artigiano mi ha detto che la maggior parte delle persone non sa dove va, ma ci sta andando di corsa. E oggi è così anche per molta filosofia professionale: dalla ragion pratica fino alla new age, certa filosofia è la maschera della logica.

Nel mese di ottobre, al Circolo della Stampa di Milano, ha presentato il progetto a cui sta lavorando. Ce ne illustra i punti chiave?

Il progetto si chiama Lessico Tomistico Biculturale (LTB).

Lo spunto è venuto dall’analisi dell’espressione di san Tommaso ratio seminalis, che era l’antico stoico λογοσ σπερματικοσ, l’anima mundi che Virgilio ha messo in versi latini molto belli. Sant’Agostino l’ha introdotto nel pensiero cristiano spiegando il Genesi e a conseguenza di questo il pensiero cristiano è stato evoluzionista, non nel senso magico di oggi, fino al Rinascimento avanzato.

Ho esaminato questa frase, che san Tommaso ha usato dieci o quindici volte più di sant’Agostino. con il metodo cui accennerò dopo e mi è risultato chiaro che san Tommaso, quando scriveva ratio seminalis (che ho trovato sempre tradotto come ragione seminale) aveva in mente quello che abbiamo in mente noi quando parliamo di «programma genetico ». Se sostituite nelle frasi di san Tommaso questa espressione, il contesto si accende come una lampadina. Non che lui conoscesse il DNA, perché ovviamente non c’erano gli strumenti di indagine, ma lui sapeva che doveva esserci un programma genetico che partiva da Dio creatore e si esprimeva in ogni individuo.

Poi c’erano le forze di base della natura; non dice quali sono, ma dice che ci sono. Per me sono luce, onde hertziane gravità eccetera, queste forze che sono a monte dell’evoluzione, che la generano.

Quando parte il progetto?

Il lessico di san Tommaso è enciclopedico ed è una sintesi di quaranta secoli di civiltà mediterranea: comincia con Abramo, frutto della civiltà e della cultura mesopotamica, circa 3000-3500 anni prima di Cristo, poi c’è il pensiero greco, il pensiero romano, il pensiero arabo e tutto il pensiero cristiano; di questi quaranta secoli, dodici sono di civiltà cristiana.  Adesso che ho tutto il suo lessico, prendo in esame san Tommaso non per quello che lo distingue dagli altri autori analoghi, ma per quello che ha in comune con tutti.

Adesso che ho tutto il suo lessico, prendo in esame san Tommaso non per quello che lo distingue dagli altri autori analoghi, ma per quello che ha in comune con tutti.

[A sinistra: Pontificia Università Gregoriana, Roma]

Allora, si tratta di prendere le sue parole una per una, avendole già divise per categorie semantiche, risalire da queste parole ai concetti che esprimevano allora (nella cultura del 1200), venire oggi (nel 2000) agli stessi concetti e da questi discendere alle parole che li esprimono e darne così la traduzione in diverse lingue. Per questo il progetto si chiama biculturale.

Sono già trent’anni che lavoro in questo senso con il metodo che spiegherò e ho analizzato decine di migliaia di contesti. Ci sono parole come «esperienza » e «espressione» che hanno circa lo stesso valore che i nostri espressione ed esperienza.

Ci sono altre parole invece che hanno significati molto maggiori. Per esempio, virtus-virtutis non si può tradurre sempre con «virtù» perché virtus ha tutto il vocabolario dell’energia, forza, professionalità, potenza. E anche la parola ordo-ordinis, che ho analizzato in 10 000 contesti, non può essere tradotta sempre con «ordine»: nel latino di san Tommaso non voleva ancora dire precetto, comando e neppure in Dante Alighieri.

Ordo-ordinis esprime tutto il vocabolario della organizzazione, pianificazione, progettazione, programmazione, tutti i concetti di struttura e sistema, quelli di tassonomia e classificazione oltre a indicare categorie professionali.

Poi spiritus: tante volte è spirito, altre volte è spinta, impulso, pulsione oltre che spirito nel senso di spirituale o anche fantasma.

Allora ci spiega il metodo che propone?

Il metodo. Prendo, di una parola, tutti i contesti, tutte le frasi che la contengono; su queste frasi inserisco i codici delle correlazioni sintattiche, elementari e dirette; in parole correnti i codici che specificano l’analisi grammaticale e logica di questa parola, frase per frase.

Questo è un lavoro da «sgobboni » però è la forma profonda e solida di pensare. Mi aspetto che qualcuno mi dica che è puerile ma ho già la risposta pronta: provi a farla, anche solo su 100 frasi, non su 10 000 come le ho fatte per ordo o su 20 000 per spiritus e si accorgerà della difficoltà.

Perché il pensiero e l’espressione sono disparati e il pensiero è multidimensionale, eccentrico e a-centrato: non si riesce mai a trovare i confini di un concetto, se ne trova subito un altro; per questo parlo di unità lessicali più che di unità concettuali. Invece l’espressione è sequenziale, tabulata come le battute di una musica, però «liofilizza » un concetto.

In periferia, in tutto il mondo dovremo trovare persone che sappiano il latino, che siano sgobboni, che non disdegnino gli antichi. Se hanno queste qualità possono partecipare al progetto. A ognuno viene data una parola su cui devono essere eseguite tutte le sintesi di correlazioni con una cascata di programmi monofunzione: non un programma come quello per gli stipendi che fa tutto insieme in un colpo solo, perché questa è ricerca. Dai collegamenti sintattici di ogni parola con i verbi di cui è soggetto o complemento, verranno fuori i suoi significati.

Finora a me sono venuti fuori. Poi ognuno deve fare un elenco di questi significati nella propria lingua: inglese, spagnolo, tedesco eccetera…

Poi i risultati vengono inviati a Roma dove, per prima cosa, un comitato certifica la qualità del lavoro. Questo è indispensabile.  Poi, all’interno di seminari tra esperti di vari paesi e lingue, bisogna esaminare i significati di questi concetti per tradurli nelle diverse lingue e nelle diverse culture contemporanee. Tra l’altro, chi fa l’esame sintattico di una voce deve analizzare le desinenze: per esempio deve dire quando veni è imperativo, quando è passato remoto eccetera, quando rosae è genitivo, ottativo, eccetera; io segnalo solo, in una nota, se la parola è omografa.

Poi, all’interno di seminari tra esperti di vari paesi e lingue, bisogna esaminare i significati di questi concetti per tradurli nelle diverse lingue e nelle diverse culture contemporanee. Tra l’altro, chi fa l’esame sintattico di una voce deve analizzare le desinenze: per esempio deve dire quando veni è imperativo, quando è passato remoto eccetera, quando rosae è genitivo, ottativo, eccetera; io segnalo solo, in una nota, se la parola è omografa.

Questo progetto è la continuazione di tutto quello che ho fatto finora. Ci lavoro da quindici anni e ora è nato a Roma un consorzio tra sei università: Gregoriana, Salesiani, Domenicani, Opus Dei, Servi di Maria, Laterano, più la Sapienza statale di Roma con l’istituto di Tullio Gregory.

L’iniziativa si è sviluppata piano piano e adesso è patrocinata da due gruppi. Il primo con Antonio Fazio, Hans Tietmayer e Michel Camdessous e anche i due cardinali Re e Tettamanzi. Il secondo è la CAEL (Computerizzazione delle Analisi Ermeneutiche e Lessicologiche), continuazione del CAAL (Centro Automazione Analisi Linguistica) che per trent’anni con la IBM ha finanziato l’Index Thomisticus.

Nel mese di dicembre i due gruppi si incontreranno per definire la forma di collaborazione allo stesso scopo. Si cercheranno i finanziamenti con l’intenzione di spendere il meno possibile. Perché, diversamente da quanto avviene di solito (prima i soldi, poi una sede pomposa, poi il lavoro), noi abbiamo cercato prima l’idea, poi il lavoro e i soldi sono sempre venuti. I progetti son come semi che bisogna gettare e piano piano cresceranno.

Un’altra importante novità nel metodo di lavoro è la sperimentazione di una collaborazione internazionale tra diverse università attraverso un lavoro in equipe in rete (e-mail, teleconferenza) e i loro sviluppi. A Roma c’è già un piccolo nucleo di persone che sarà il centro di questo lavoro in rete.

Per concludere, vorrei ripetere che l’informatica e i computer sono un dono di Dio che Lui ha preparato dagli inizi del mondo. Oggi purtroppo in questo campo c’è una grande confusione: primo ne parlano troppo quelli che non ne sanno, secondo ne parlano i sognatori facili, che desiderano far denaro velocemente.

Invece dobbiamo dire che le potenzialità dell’informatica non sono esaurite, stanno ancora «cabrando». Gli aeroplani ci hanno messo 100 anni a perfezionarsi, queste cose ce ne metteranno altrettanti, piano piano.

«Siccome il computer è figlio dell’uomo e l’uomo è figlio di Dio, allora il Signore Dio guarda il computer come un nonno guarda i suoi nipotini. Guai a parlarne male e a usarlo male.» |

Per contribuire solidamente a questo sviluppo basta che ognuno cominci a fare il poco che è utile a lui: questo fa crescere vitalmente le strutture nuove. Però bisogna mettersi a lavorare su una linea precisa e definita.

Volete un ultimo aforisma?

Il computer può essere usato bene per il bene, può essere usato male per il bene e può essere usato bene anche per il male.

Vai all’articolo in formato PDF

A cura di Maria Cristina Speciani (Caporedattore della Rivista Emmeciquadro) e Vittorio Sacchi (Docente di Matematica nelle Scuole Secondarie di Secondo Grado)

Roberto Busa S.J.

Nato a Vicenza nel 1913, è tuttora in piena attività. Ha insegnato alla Pontificia Università Gregoriana, all’Aloisianum di Gallarate e all’Università Cattolica di Milano. Dal 1995 al 2000 ha insegnato al Politecnico di Milano nell’ambito dei corsi di Intelligenza Artificiale e robotica tenuti da Marco Somalvico. «1261 momenti di pensiero distillati » da questo corso sono stati pubblicati nel 2000 da ITACAlibri in Dal computer agli angeli. Autore di numerosissimi saggi. La sua opera fondamentale, l’Index Thomisticus, pubblicato tra il 1974 e il 1980 in 56 volumi e oggi disponibile anche su cdrom, è il risultato della elaborazione computazionale dei testi di san Tommaso e ha costituito la base di qualsiasi ulteriore ricerca di informatica linguistica.

© Pubblicato sul n° 13 di Emmeciquadro

«Agli inizi l’obiettivo primo erano 12 milioni di schede perforate con stampato sul dorso un contesto di 11 righe. Ne sarebbe risultato uno schedario unico di 90 metri di fronte, 1,20 di altezza e 1 di profondità: peso complessivo 500 tonnellate. Dopo che ne ebbi perforato sei milioni, la misericordia del Signore ha fatto inventare agli uomini i nastri magnetici. […] Ebbi da allora in lavorazione un parco di 1800 nastri magnetici, di 2400 piedi cioè 800 metri ciascuno: erano circa 1500 kilometri di nastro, presso a poco la distanza tra Milano e Palermo o tra Parigi e Lisbona. […] Per cui la prima epoca fu quella delle 500 tonnellate di schede, la seconda fu quella dei 1800 nastri magnetici. Terza epoca è ora quella di 1 solo cd-rom.»

«Agli inizi l’obiettivo primo erano 12 milioni di schede perforate con stampato sul dorso un contesto di 11 righe. Ne sarebbe risultato uno schedario unico di 90 metri di fronte, 1,20 di altezza e 1 di profondità: peso complessivo 500 tonnellate. Dopo che ne ebbi perforato sei milioni, la misericordia del Signore ha fatto inventare agli uomini i nastri magnetici. […] Ebbi da allora in lavorazione un parco di 1800 nastri magnetici, di 2400 piedi cioè 800 metri ciascuno: erano circa 1500 kilometri di nastro, presso a poco la distanza tra Milano e Palermo o tra Parigi e Lisbona. […] Per cui la prima epoca fu quella delle 500 tonnellate di schede, la seconda fu quella dei 1800 nastri magnetici. Terza epoca è ora quella di 1 solo cd-rom.»