La questione terremoti, nel nostro paese tuttora purtroppo di grande attualità, suscita tante domande e trova in risposta, soprattutto nei media a grande diffusione o sui social, informazioni anche interessanti che tuttavia, senza un quadro sintetico, restano, per chi le ascolta, frammentarie e incomprensibili.

Nella prima parte del contributo, pubblicata sul n° 64 – Marzo 2017 di questa rivista, l’autore, ricercatore dell’INGV, ha presentato la complessità e le difficoltà degli studi sismici, soprattutto nella prospettiva di evitare il ripetersi di fenomeni tragicamente distruttivi.

In questa seconda parte, ci aiuta a capire il significato dei parametri utilizzati dalla sismologia per descrivere i terremoti e la loro importanza per programmare rilievi di tipo geofisico e tecniche per accelerare gli interventi di protezione civile.

| Vai alla Home-Page della Rivista | Chi Siamo | Vai al Sommario del n° 65 – Giugno 2017 |

| Vai alla Sezione SCIENZAinATTO | Vai agli SPECIALI della RIVISTA |

Nel precedente articolo (Emmeciquadro, n° 64 – Marzo 2017) avevo accennato al fatto che sono nume-rosi i parametri che si ottengono dai dati sismometrici dopo un terremoto. Si tratta di informazioni utili alla Protezione Civile per calibrare il tipo e l’entità dell’intervento nelle zone colpite dal sisma, ma anche di parametri scientifici che permettono di studiare il fenomeno in corso e fare ipotesi, purtroppo solo quelle, sulla sua evoluzione.

Tutto questo è reso possibile da una capillare distribuzione delle stazioni sismiche sul territorio italiano, dalla collaborazione degli enti nazionali con le reti dei paesi limitrofi, soprattutto per gli eventi che avvengono al confine tra nazioni, da un sistema di trasmissione dati di ultima generazione e l’utilizzo di software che, almeno nella primissima fase della elaborazione, affiancano con procedure automatiche gli operatori di sala sismica, ovvero il luogo fisico dove i segnali sismici vengono raccolti ed elaborati.

La sala sismica

Durante una emergenza sono due le priorità di cui tenere conto: la rapidità con cui vengono emessi i comunicati relativi agli eventi e l’accuratezza delle informazioni ivi contenute. Tutti e due concorrono a un intervento ottimale e speditivo in emergenza.

Per questo la sala sismica assomiglia un po’ a un pronto soccorso medico: nella maggior parte del tempo la situazione è di calma piatta, magari rotta solo da qualche terremoto di magnitudo sopra la media. Ma quando si verifica l’emergenza e un forte evento sismico interrompe la routine, scattano una serie di attività che, come in un pronto soccorso, prevedono una sequenza ben definita e priva di errori per assicurare una pronta e accurata definizione di tutti i parametri di quel fenomeno. Per capire l’impatto che un forte terremoto può avere, basti ricordare che, dall’agosto 2016 all’aprile 2017, INGV ha registrato circa 66000 terremoti (circa 3 volte il numero medio annuale nella nostra penisola) solo nell’Appennino Centrale: in pratica circa 300 terremoti al giorno.

Sul territorio italiano sono più di 400 gli strumenti che registrano le vibrazioni del terreno. La densità di questi rilevatori è, in linea di massima, legata alla pericolosità sismica.

Tuttavia, la qualità della localizzazione di un terremoto dipende dalla completezza azimutale delle informazioni (ovvero dalla distribuzione delle stazioni intorno all’epicentro) e allo scopo di coprire in maniera adeguata anche le zone marine, dove sussistono obiettive difficoltà tecniche ad installare strumenti sismici, vi sono stazioni anche in regioni, come la Sardegna, dove la sismicità è molto scarsa ma che risulta strategica per registrare i raggi sismici che attraversano il Tirreno.

Il numero di sismometri nella sua attuale configurazione è in grado di rilevare, registrare e localizzare terremoti con magnitudo inferiore a 1 e, in alcuni casi, anche negativa.

[A sinistra: Stazioni sismiche.

[A sinistra: Stazioni sismiche.

In Italia operano circa 400 stazioni sismiche velocimetriche (rappresentate dai triangoli blu) e 530 accelerometriche. Ambedue registrano il movimento del terreno ma secondo le due diverse grandezze fisiche, velocità e accelerazione.

In particolare, la seconda serie di strumenti è adatta alla rilevazione di terremoti molto forti e ha implicazioni dirette per l’ingegneria]

A compendio di questi strumenti fissi, esiste inoltre una rete mobile di pronto intervento in grado di aumentare la densità, e quindi la qualità, delle informazioni in caso di particolari necessità. Il suo utilizzo è previsto quando sia utile indagare su una particolare zona la cui attività potrebbe sfociare in un sisma di energia significativa o più semplicemente per aumentare la quantità di informazioni subito dopo un grande terremoto.

È infatti da notare che uno dei parametri che «fotografano» le caratteristiche del terremoto, ovvero la profondità a cui esso avviene, è particolarmente sensibile alla distanza della più vicina stazione sismica.

La profondità dell’ipocentro ha a sua volta implicazioni importanti sulla entità del danneggiamento poiché, come intuibile, la maggiore vicinanza del sisma alle fondamenta degli edifici è causa di maggiori danni. Intervenire sul territorio con ulteriori strumenti permette di vincolare in maniera più accurata questo parametro e, in conseguenza, di definire con maggiore certezza quale struttura geologica può essersi mossa causando l’evento.

Subito dopo un sisma, dunque, si attuano operazioni volte a definirne la posizione geografica (epicen-tro), la profondità (ipocentro), una lista di comuni potenzialmente interessati dallo scuotimento, il tempo origine in cui è avvenuta la rottura della faglia e la magnitudo.

Ai fini di Protezione Civile sapere dove si è verificato un terremoto è una parte della informazione con cui decidere un eventuale intervento. Infatti solo nel caso in cui il sisma abbia superato una certa soglia di magnitudo (3.0) si può ragionevolmente ipotizzare che si siano verificati dei disagi o dei danni e sia necessario intervenire.

La determinazione della prima posizione del terremoto deve necessariamente essere rapida, e viene completata in meno di due minuti utilizzando algoritmi automatici. Intanto viene anche pubblicata una prima stima della magnitudo che, se eccede il valore di soglia stabilito, può rendere necessario l’intervento di emergenza.

Chi cambia la magnitudo?

Talvolta accade che il primo valore di magnitudo, proposto pochi minuti dopo l’evento sismico, sia di-verso da quello che viene poi definitivamente reso noto circa mezz’ora dopo. Questa fisiologica diffe-renza, spesso attribuita a perverse macchinazioni e complotti, è semplicemente dovuta al modo in cui viene condotto il calcolo.

La magnitudo è una misura della «forza» del terremoto proposta da Charles Richter nel 1935, agli albori della sismologia strumentale. Gli strumenti di cui disponeva il noto sismologo avevano degli ovvi limiti: erano strumenti meccanici, con una sensibilità relativamente limitata in grado di registrare bene i terremoti di media energia, ma tendevano a «saturare» in caso di terremoti molto forti o per strumenti a poca distanza da un sisma di media forza. O al contrario risultavano sordi verso movimenti del terreno troppo piccoli o comunque molto lontani dall’apparecchiatura di rilevamento.

Gli strumenti moderni sono molto più sensibili e per questo motivo si possono attualmente misurare magnitudo molto piccole, addirittura negative.

Il concetto su cui si basa la magnitudo è molto semplice, simile a quello con cui si misura la intensità luminosa di una stella (da qui il nome, simile a magnitudine appunto) e dipende sia dalla sua energia che dalla distanza a cui il terremoto viene registrato. Si può dunque calcolare la magnitudo anche con un solo sismogramma, quindi in tempi brevissimi, misurandone l’ampiezza, che è a sua volta proporzionale alla oscillazione del terreno, posto che sia nota la distanza di quello strumento dal sisma.

Infatti, proprio come accade per le stelle, quella registrazione può corrispondere a un sisma forte e lontano o meno forte ma vicino e solo la conoscenza della distanza può sciogliere il dubbio.

La magnitudo è regolata da una legge logaritmica e per passare da un valore al successivo l’ampiezza del sismogramma deve aumentare 10 volte. Così abbiamo magnitudo 3 quando l’ampiezza sulla regi-strazione è 1 mm per uno strumento posto a 100 km di distanza, 4 quando nelle stesse condizioni la ampiezza è 10 mm e così via.

Ovviamente i sismometri non sono mai, se non in maniera casuale, posti esattamente a 100 km di distanza; con un fattore correttivo si può calcolare la magnitudo anche per distanze inferiori o superiori.

Anche se gli strumenti sismici utilizzati sono di nuova generazione e quindi molto più performanti di quelli di Richter, tuttavia per il calcolo della magnitudo si deve simulare la risposta che avrebbe lo strumento originale, comprese le sue limitazioni. È chiaro che la «saturazione» si raggiunge anche per valori relativamente bassi se lo strumento è molto vicino all’epicentro.

Il sistema proposto da Richter è molto efficiente perché rapido e basato su semplici misure ma è impreciso, soprattutto per magnitudo superiori a 6, per le quali, per quanto visto sopra, tende ad «appiattire» i valori perché oscillazioni molto grandi sul sismogramma vengono tagliate sul massimo valore possibile della escursione del pennino di registrazione.

È come se versassimo diversi volumi di liquido (terremoti più o meno forti) in un bicchiere di capacità massima nota (sensibilità dello strumento). Indipendentemente da quanto è il volume iniziale, la quantità di liquido al di sopra della capacità del bicchiere viene persa e i volumi finali stimati appariranno uguali e pari alla capacità del bicchiere. In particolare, il valore 6.0 è all’incirca il limite al di sopra del quale la magnitudo Richter non è più affidabile, e occorre calcolarne il valore con un algoritmo più complesso che richiede però più tempo.

Il metodo speditivo è dunque sicuramente utile a fornire l’ordine di grandezza della severità del sisma, e continua a essere utilizzato con successo per questa finalità, ma deve essere sostituito da una misura più precisa e indipendente dal tipo di strumento utilizzato.

Per questo, non appena possibile, viene calcolata la Magnitudo Momento, che a differenza della magnitudo Richter ha anche significato in termini di estensione dell’area in movimento. Tuttavia può succedere che i valori calcolati con i diversi approcci siano leggermente differenti. Questo causa quel dualismo che talvolta crea così tanto sconcerto nel pubblico.

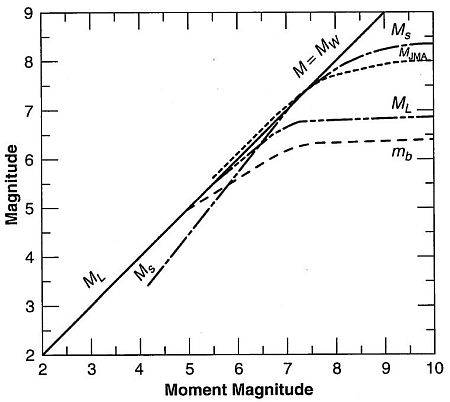

[A destra: Curva delle magnitudo.

[A destra: Curva delle magnitudo.

La figura mostra il rapporto tra la magnitudo «assoluta» (Magnitudo Momento, indipendente dal tipo di strumento che registra il sismogramma) e quella originale di Richter.

In particolare si osserva che la curva ML, normalmente usata per la stima di magnitudo per terremoti vicini, «piega» intorno al valore 6.0 e si allontana dalla linea della Magnitudo Momento (MW).

Al di sopra di quei valori la magnitudo Richter tende a sottostimare l’entità del sisma, ed è più corretto sostituirla con il calcolo della MW]

La conoscenza del più esatto valore di magnitudo ha conseguenze anche sulla stima delle energie in gioco. Va sottolineato che, fortunatamente, una gran parte dell’energia rilasciata durante un sisma viene dissipata in calore e solo una piccola frazione si trasforma in scuotimento.

La relazione tra magnitudo ed energia prevede che all’aumento di un valore di magnitudo corrisponda un aumento di circa 30 volte l’energia rilasciata. L’incremento è di mille volte se il passaggio è tra due unità di magnitudo e così via. Di conseguenza, una stima dell’esatto decimale, apparentemente trascurabile, ha invece conseguenze nel bilancio energetico del fenomeno.

Un problema che si riscontra spesso è quello della confusione tra magnitudo e intensità. La seconda fu proposta dal sacerdote Giuseppe Mercalli, che riorganizzò scale di misura di danni già utilizzate ma inadeguate alla complessità dei fenomeni che si osservano dopo un terremoto. L’attribuzione della intensità viene fatta confrontando i danni sugli edifici, sulle infrastrutture e le testimonianze dell’evento con le relative descrizioni per i vari valori di scala previste da Mercalli.

Per esempio, in una sua versione più moderna (scala MCS, Mercalli-Cancani-Sieberg), al grado IX si legge: «circa la metà delle case in pietra sono seriamente distrutte, molte crollano, la maggior parte diviene inabitabile. Case ad intelaiatura sono divelte dalle proprie fondamenta e compresse su se stesse, in tal modo vengono tranciate le travi di supporto degli ambienti ed in presenza di tali circostanze esse contribuiscono a distruggere considerevolmente le case». Se una località presenta tale situazione, ad essa viene attribuito il nono grado.

Va da sé che, a differenza della magnitudo che è unica per il terremoto, l’intensità varia a seconda della vicinanza all’epicentro, alle caratteristiche costruttive degli edifici e così via. Vi saranno quindi diversi valori di intensità per la stessa magnitudo.

Purtroppo spesso anche i media confondono i due modi di valutare la forza del terremoto e ciò, insieme al «ritocco» della magnitudo per i problemi strumentali sopra descritti, contribuisce alle lunghe discussioni a cui abbiamo assistito nel passato e relative alla definizione di «comune sismico», cioè da inserire nel criterio di distribuzione di aiuti post-terremoto.

Per pura combinazione, viene considerato sismico un comune che ha sperimentato una intensità superiore a VI (se si usasse correttamente il numero romano forse molti problemi sparirebbero), che sarebbe osservabile in teoria anche per terremoti di magnitudo piccoli ma molto vicini all’abitato. Ma 6 è anche il valore oltre il quale la magnitudo deve essere calcolata con un criterio più rigoroso, e per questo talvolta oscilla tra valori al di sotto e al di sopra.

Così un aggiustamento della magnitudo viene spesso confuso per un cambiamento della intensità, e crea movimenti di pensiero, soprattutto sui social, contro il fantomatico complotto dello Stato per non rifondere i danneggiati.

La posizione del sisma non basta

Torniamo ora al pronto soccorso sismico. Molti altri parametri vengono calcolati dai sismologi durante la revisione dei sismogrammi per «validare» la localizzazione con una procedura manuale. Infatti, in casi particolarmente complessi, l’esperienza umana si rivela fondamentale per aumentare la precisione nella posizione e magnitudo del terremoto.

Come risultato di questa revisione viene riproposta la lista, eventualmente aggiornata, dei comuni più vicini all’epicentro con relativo numero di abitanti e vengono calcolate delle mappe di scuotimento (shake maps) che rappresentano con diversi colori i gradi di severità di danno attesi per aree a distanze crescenti dalla posizione del terremoto, espressi anche in intensità.

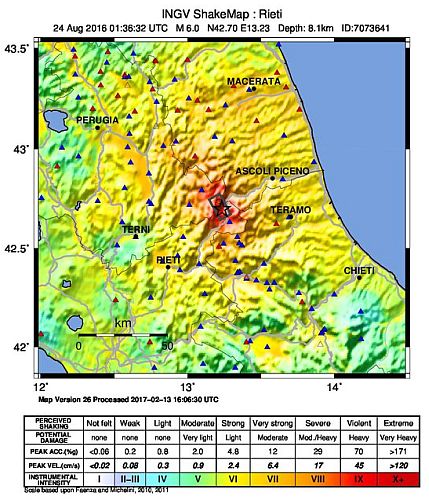

[A sinistra: Shake map calcolata per il terremoto del 24 Agosto 2016.

[A sinistra: Shake map calcolata per il terremoto del 24 Agosto 2016.

I diversi colori si riferiscono alla legenda in basso e sono relativi alla scala MCS, una versione aggiornata della scala Mercalli. Sono anche fornite in legenda delle stime ipotetiche di risentimenti e danni.

La mappa viene elaborata subito dopo il terremoto e può essere utile a inquadrare la severità del fenomeno e le dimensioni dell’area interessata da potenziali danni (colori da giallo a rosso).

L’estensione geografica è di solito limitata alle zone più colpite, ma lo scuotimento ha interessato, senza danni, un’area molto più vasta]

Inoltre un apposito sito (www.haisentitoilterremoto.it) raccoglie le segnalazioni dei cittadini per costruire una mappa simile a quella di scuotimento ma basata su testimonianze reali (sensazioni, suoni e rumori, danni).

Tutti questi dettagli si trasformano in ulteriori, preziose informazioni per organizzare al meglio gli interventi sul territorio da parte della Protezione Civile. Ma sono anche rese disponibili al pubblico su una pagina web creata apposta per l’evento (http://cnt.rm.ingv.it/ e relativi link) con tutte le informazioni necessarie a inquadrarne gli aspetti scientifici.

Vi si trovano infatti, per l’area interessata da quel sisma, la sismicità storica (dall’anno 1000), quella degli ultimi 3 e 90 giorni, quella a partire dal 1985, il meccanismo focale (ovvero una rappresentazione del modo in cui si è mossa la faglia che ha generato il sisma), la pericolosità sismica e i principali sismogrammi per una eventuale rielaborazione.

Terminate le operazioni di emergenza, diciamo da qualche giorno a qualche settimana dopo il sisma, vengono compilati i censimenti sui danni in base ai quali vengono attribuiti ufficialmente i valori di intensità alle varie località colpite. È in questa fase che viene definito il «cratere», ovvero la zona che sarà oggetto di ricostruzione.

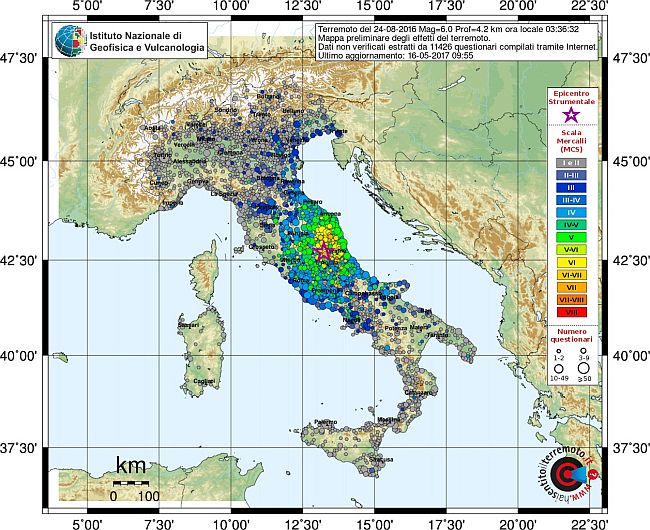

Mappa compilata con le informazioni fornite dal pubblico e redatta con criteri simili alla shake map La maggiore estensione della mappa rispetto alla precedente è dovuta al fatto che un terremoto 6.0 in Appennino Centrale viene risentito in un’area molto ampia, e le informazioni arrivano da ogni parte d’Italia.

Mappa compilata con le informazioni fornite dal pubblico e redatta con criteri simili alla shake map La maggiore estensione della mappa rispetto alla precedente è dovuta al fatto che un terremoto 6.0 in Appennino Centrale viene risentito in un’area molto ampia, e le informazioni arrivano da ogni parte d’Italia.

Vi sono dunque contenute anche informazioni che non hanno diretto interesse ingegneristico ma sono comunque utili a inquadrare l’impatto sulla popolazione.

Il confronto tra le mappe costruite con le osservazioni reali e quelle ipotizzate subito dopo il sisma mostra talvolta delle incongruenze che, sostanzialmente, trovano spiegazione nei cosiddetti effetti di sito. Infatti le shake maps teoriche sono calcolate ipotizzando che il terreno sia ovunque uguale e formato da roccia, ma sappiamo bene che nella realtà non è così.

Nel tragitto di un’onda la varietà geologica ha una conseguenza diretta sulla sua energia. Infatti un’onda sismica che attraversa uno strato roccioso passa imperturbata attraverso quel volume, mentre una che attraversa uno strato sedimentario, oppure raggiunge un alto topografico, può venire amplificata anche in maniera significativa.

Ecco perché talvolta, anche all’interno di una stessa città, si osservano danni differenti per gruppi di edifici simili. La conoscenza della geologia crostale assume quindi grande importanza nello scenario di danno di un possibile sisma.

La nostra nazione è al momento sottoposta a un’importante operazione di Microzonazione Sismica, ovvero al riconoscimento puntuale di fattori che possono amplificare le onde sismiche.

Nuovi sviluppi, più sicurezza?

La possibilità di registrare terremoti in un gran numero di punti della nostra penisola potrebbe avere anche qualche implicazione dal punto di vista della sicurezza e dell’allerta sismica. Infatti una distribuzione capillare di stazioni sismiche permette di sfruttare alcune delle caratteristiche dei terremoti per eventualmente emanare allarmi durante l’evento. Non si tratta di previsioni, è doveroso sottolinearlo, ma di studi per eventuali applicazioni future.

Subito dopo il movimento della faglia, dall’ipocentro dipartono diversi tipi di onde, con caratteristiche e, soprattutto, velocità diverse. Chi ha sperimentato un terremoto sa che durante il sisma si provano due tipi distinti di scuotimento, uno verticale e uno orizzontale e che tra i due trascorre un intervallo di tempo. La durata di questo intervallo dipende da molti fattori ma principalmente dalla distanza del sisma.

Il ritardo è legato al fatto che le onde P, che originano uno scuotimento di tipo compressivo, quindi da noi percepito come un movimento alto-basso, viaggiano più velocemente delle onde S, che invece originano uno sforzo di taglio che a noi risulta come un movimento orizzontale avanti-indietro, destra-sinistra, e infine delle onde di superficie, lo scuotimento dovuto alle quali è molto complesso, non per niente si tratta delle onde più dannose.

Le onde P sono di solito meno energetiche e distruttive delle onde S e di superficie, quindi se fosse possibile sfruttare il ritardo nei tempi di arrivo tra le onde, si potrebbe utilizzare tale intervallo di tempo per compiere, in maniera più o meno automatica, delle azioni di sicurezza (fermare i treni, per esempio). Ovviamente il successo di questa operazione è assicurato solo nel caso in cui l’intervallo di tempo sia sufficiente ad agire e se la trasmissione dell’informazione è repentina e rapida.

In pratica alla prima stazione che rileva l’onda P viene calcolata la posizione iniziale, la magnitudo del terremoto e la shake map. Subito dopo vengono allertate tutte le località poste sul tragitto delle onde per le eventuali operazioni di sicurezza, che possono essere messe in atto nell’intervallo di tempo tra l’arrivo delle onde.

È interessante notare che, in linea di massima, questo approccio si potrebbe anche applicare ad altre emergenze naturali; per esempio sapendo che una tempesta interessa una certa zona e potendo calcolare il probabile tragitto della perturbazione, sarebbe possibile emanare un’allerta per le zone interessate dal movimento del fenomeno temporalesco.

Questo approccio prende il nome di early warning (allarme precoce); dipendendo dalla distanza del sisma rispetto alla zona da allertare, il tempo a disposizione per prendere provvedimenti varia da alcuni secondi ad alcune decine di secondi. Da quanto detto sopra è evidente che prima avviene la determina-zione dei parametri, più efficiente sarà il sistema.

Vi è quindi una relazione diretta tra probabilità di riuscita e numero di stazioni sul territorio. Per ovviare, almeno in parte, alla insufficiente distribuzione di stazioni sismiche sul territorio (400 sono molte per operazioni di routine, ma decisamente ancora poche per un early warning) si stanno vagliando possibilità alternative come l’utilizzo degli smartphone (che sono spesso dotati di accelerometri): ogni possessore di tale telefono potrebbe diventare una stazione sismica, capillarmente distribuita sul territorio.

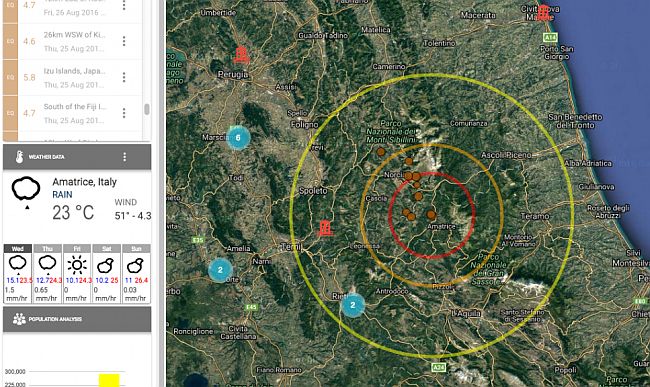

Una schermata esempio del sistema di early warning disponibile attraverso il laboratorio geoSDI dell’Imaa-Cnr

Una schermata esempio del sistema di early warning disponibile attraverso il laboratorio geoSDI dell’Imaa-Cnr

Si pensa però anche ad approcci alternativi, come il flusso delle informazioni sui social network. Il tempo che impiega un messaggio digitale per raggiungere un punto lontano è in genere più breve di quello che impiegano le onde sismiche per lo stesso tragitto e siccome i web surfer sono molti precoci nel comunicare quello che accade, l’improvviso aumento di comunicazioni da una certa località potrebbe essere utilizzato come sistema di allarme.

Tuttavia occorre ricordare che le azioni di reazione all’evento funzionano solo se la società e l’ambiente sono preparati all’evenienza e adeguatamente educati. Il caso del maremoto del Giappone del 2011 è emblematico: abbiamo seguito in diretta l’evolversi del fenomeno, sapevamo quello che stava succedendo e sarebbe da lì a poco accaduto, tuttavia la sottostima delle contromisure rispetto all’entità del fenomeno ha trasformato l’evento in una ecatombe.

Dopo l’emergenza, cosa succede ai dati?

Finita l’emergenza, i dati archiviati vengono utilizzati per un’interpretazione ragionata del fenomeno con l’intento di conoscere di più e meglio l’accaduto. Spesso occorrono molti mesi per l’interpretazione della importante mole di informazioni acquisite.

Così, per esempio, la ricostruzione delle variazioni della posizione degli ipocentri durante una sequenza indica quali porzioni della faglia si sono mosse, con quale tempistica, se hanno interessato strutture limitrofe, se sono potenzialmente in grado di innescare movimenti in altri rami della faglia, quanto è l’estensione verticale delle faglie interessate e così via.

Ogni terremoto, studiato con un numero via via crescente di informazioni, aggiunge dettagli a un quadro spesso molto complesso. Come già detto, in genere si muovono strutture sepolte a molti chilometri di profondità, non visibili dalla superficie e quindi con una forma ipotizzabile con le sole informazioni indirette.

La sismologia è una scienza relativamente giovane e, fino a pochi anni fa, non era possibile altro che individuare il movimento delle placche in maniera globale, senza poter ricostruire i meccanismi locali che portano a deviazioni rispetto al moto generale.

La scarpata di faglia sul monte Vettore, ampliatasi dopo il terremoto del 30 ottobre 2017

La scarpata di faglia sul monte Vettore, ampliatasi dopo il terremoto del 30 ottobre 2017

Siamo ancora in alto mare, tuttavia abbiamo capito, grazie agli eventi dell’ultimo decennio, che la complessità della situazione italiana necessita di informazioni più dettagliate., Per questo le cerchiamo con approcci in grado di definirne le caratteristiche, magari con metodi presi a prestito da altre discipline come per esempio la tomografia sismica.

Essa, come accade per la TAC medica, è in grado di restituire una possibile immagine dell’interno della Terra sfruttando il passaggio delle onde sismiche per ricostruire zone a diversa velocità e fratture. Oppure, se vogliamo in maniera un po’ paradossale visto che il target è l’interno della Terra, studiamo i fenomeni con le informazioni che provengono dai satelliti, che oggi assicurano una sensibilità dell’ordine del centimetro.

Per esempio, nel caso del recente terremoto dell’Appennino, grazie ai satelliti si è osservato uno spostamento di Norcia fino a 30-40 centimetri verso Ovest, in direzione di Spoleto; e lo sprofondamento fino a oltre 70 centimetri della piana di Castelluccio.

Questo ci ha aiutato a capire che il movimento delle placche (la sequenza in Appennino ha mosso 1100 metri quadrati di roccia) non avviene solo nella direzione principale di movimento ma secondo direzioni preferenziali dettate dalle caratteristiche locali.

Rimane aperto il problema della relazione tra i tre grandi eventi che si sono verificati in Italia tra il 2009 ed il 2016, tema sul quale la comunità scientifica è fortemente impegnata.

| Vai al PDF di questa seconda parte dell’articolo |

| Vai al PDF della prima parte | Vai alla prima parte dell’articolo ON-LINE |

| Vai alla Home-Page della Rivista | Chi Siamo | Vai al Sommario del n° 65 – Giugno 2017 |

| Vai alla Sezione SCIENZAinATTO | Vai agli SPECIALI della Rivista |

Stefano Solarino

(Sismologo, Primo Ricercatore del Centro Nazionale Terremoti dell’Istituto Nazionale di Geofisica e Vulcanologia – INGV)

© Pubblicato sul n° 65 di Emmeciquadro